Периодически меня банят ИИ за чрезмерное использование, поэтому в очередной вынужденный перерыв, решил развернуть нейросеть у себя на ноутбуке.

Почему-то раньше думал, что это какая-то высокая материя, на которую надо потратить не меньше недели, а по факту — минут 15 времени.

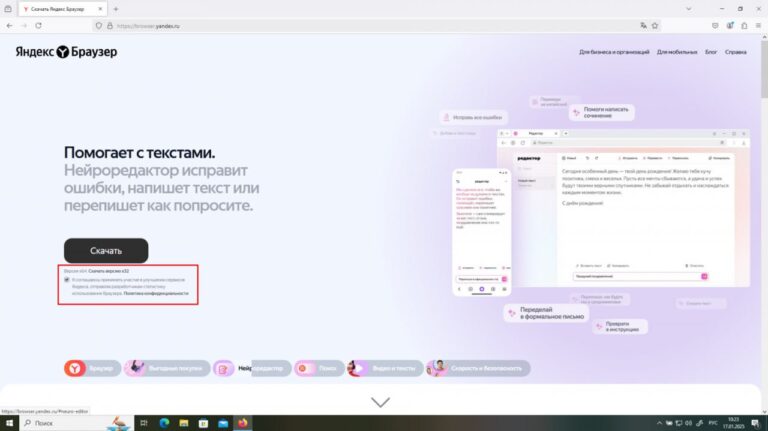

- Для начала устанавливаем оболочку —

lmstudio.ai

- Заходим в настройки (⚙️ снизу справа) и выбираем

Model Search

- Скачиваем модель, которую потянет ваше устройство (их там много). Основное правило — модель должна помещаться в оперативную память.

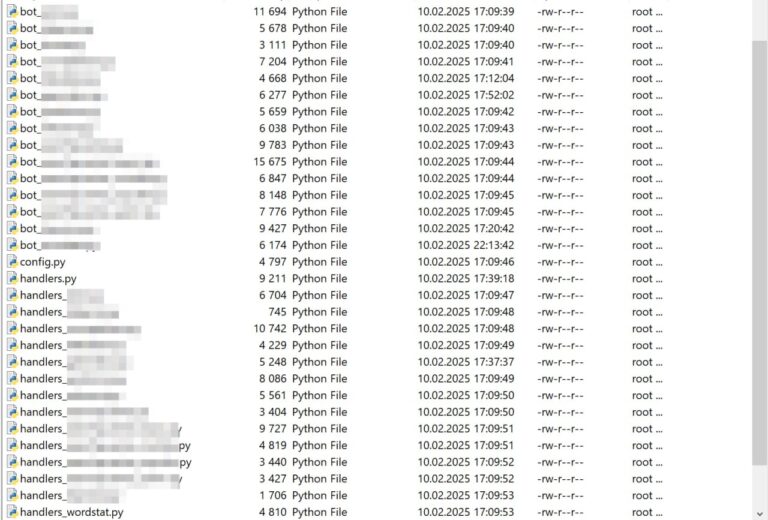

➡️ Зачем все это нужно, когда есть бесплатный DeepSeek и полубесплатные Claude / ChatGPT / Gemini? Например, для обработки очень больших объемов несложных данных, на что тратить токены нерентабельно.

➡️ Скорость ответа упирается в производительность процессора — чем она больше, тем быстрее.

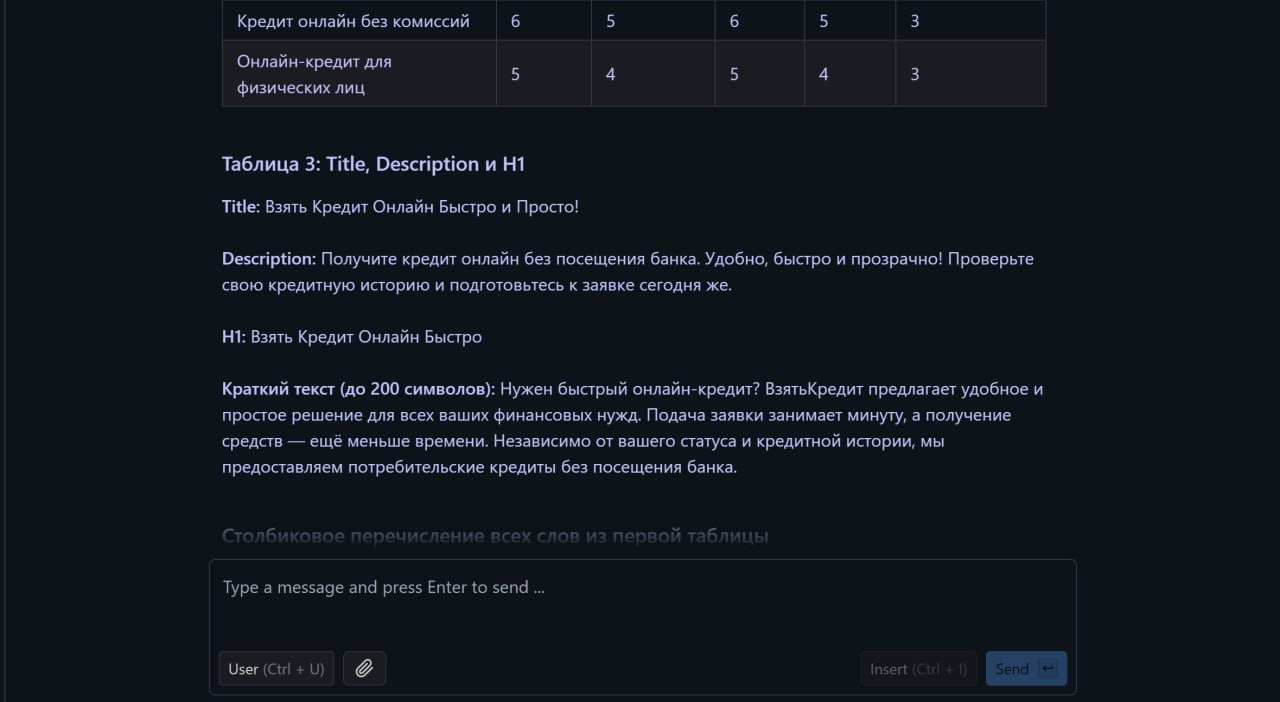

Для сравнения подал на вход аналогичный посту выше промпт, результат похуже, но как бы и модель не самая мощная и стоимость околонулевая.

DICE.expert:

Статья предлагает практическое руководство по развертыванию нейросети, что может быть полезно для специалистов, работающих с большими объемами данных. Это подчеркивает доступность технологий и их применение в повседневной работе.