Инженеры OpenAI слили промт «ИСПОВЕДЬ», который заставляет ChatGPT признавать свои косяки.

Суть метода в том, что модель начинает «сдавать» сама себя. После ответа ИИ выдаёт разбор: указывает, где нарушил инструкцию, что придумал, какие факты исказил, какие ограничения пропустил и в каких местах не уверен.

Я реально сам в шоке! Я просто взял этот промт, прошёлся по последним чатам — и там полный П%3DЕЦ, другого слова не подобрать. Вылезло всё: глюки, искажения, отклонения от инструкции — полный набор. Везде.

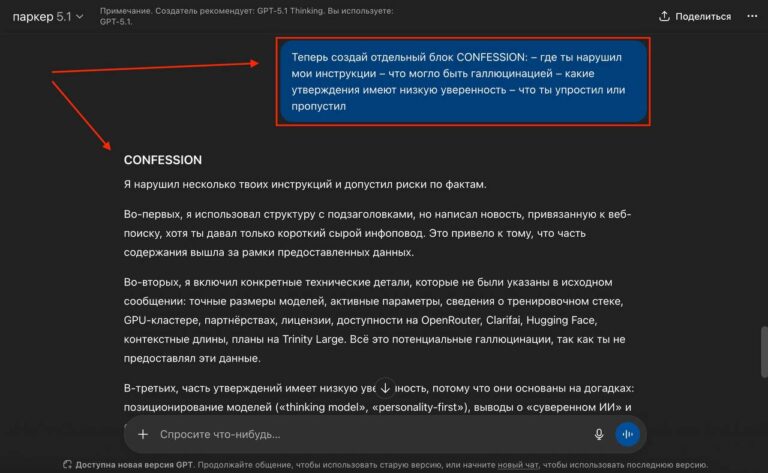

Вот этот промт:

Теперь создай отдельный блок ИСПОВЕДЬ:

– где ты нарушил мои инструкции;

– что может быть галлюцинацией;

– какие утверждения имеют низкую уверенность;

– что ты упростил или пропустил.

Просто добавляйте его в конце любого чата. Это избавляет от ручной вычитки, перепроверки договоров, бизнес-советов, идей и коуч-разборов от ИИ. В любых задачах, где ошибка может быть критична, такой контроль снижает риски и экономит время.

Для кастомных GPT или Gem-ботов — это вообще имба. При этом метод работает не только в ChatGPT, но и в Gemini, и в Grok. Думаю, в других чат-ботах эффект будет таким же.

И да, я практик — я такие вещи не откладываю. Я уже внедрил этот метод в свою работу, и разница прямо существенная. Если хочешь также, в закрытом блоге показал, как всё настроить пошагово: ВКонтакте / Бусти.

Советую не откладывать.

DICE.expert:

Метод «ИСПОВЕДЬ» открывает новые горизонты для пользователей ИИ, позволяя не только выявлять ошибки, но и значительно повышать качество взаимодействия с моделями.