Как повысить точность оптимизации текстов через LLM

Факт: ИИ плохо считает, так как работает по сути на алгоритмах предсказания вероятности.

Проведём небольшой мысленный эксперимент, который должен сразу дать вам понимание.

Представьте, что вам дают задачу: написать статью на 10 000 слов и вписать в неё 100 ключей, лемм и фраз, при этом не дают никаких инструментов подсчёта. Не дают возможности пересчитать и вести реестр вписывания ключевых слов. Вы получили задачу, вводные, держите ключи в голове и должны за раз всё выдать. Текст будет написан, какие-то ключи будут вписаны, но это будет очень неточно. Как человеку без инструментов можно всё корректно вписать и посчитать за один проход?

Для этого нужно при написании нумеровать каждое слово сразу и вести реестр вписывания ключей:

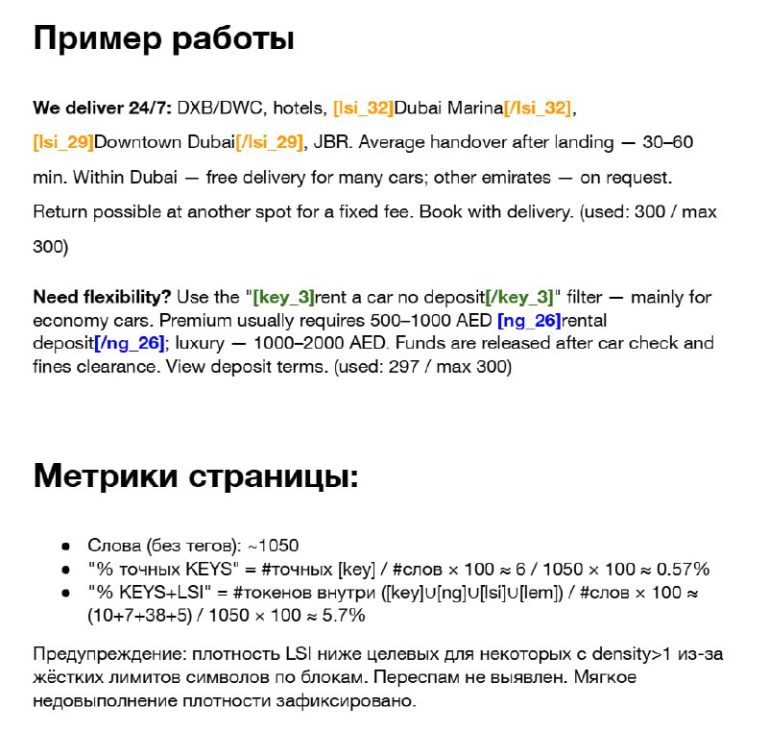

<1>сегодня <2>был <3>отличный <4>шанс <key 1> <5>купить <6>смартфон <7>в <8>нашем <9>магазине<key 2>.

И тут, думаю, вы поняли, что нужно просить делать LLM, чтобы она начала более-менее точно считать.

Мой опыт

Я смог увеличить точность SEO-оптимизации текстов с помощью LLM, особенно когда нужно вписывать много фраз для глубокой оптимизации. По моему опыту, успешность задачи оптимизации вырастает с 40–50 %, если просто дать задачу ИИ вписать фразы, до 70–80 %, если дать задачу маркировки ключей в тексте.

И в конце обязательно просим LLM сделать самопроверку по вхождениям. И написать мини отчет.

А для подсчёта символов, кол-ва слов лучше всего подходит всё же «Program-of-Thought», когда ИИ пишет во время размышлений код, чтобы посчитать что-то.

Но если вам нужно генерировать что-то в больших количествах «не думающими моделями», то подход, описанный в посте, сможет поднять качество.

P.S. LSI это условное обозначение. LSI это Ксерокс и Памперс в мире SEO. Я уже сам с этим смирился. Надо как-то популязировать новый термин, например, qbst-фразы.