Рубрика: одна интересная SEOшница в Линкединах сказала

Пересказ:

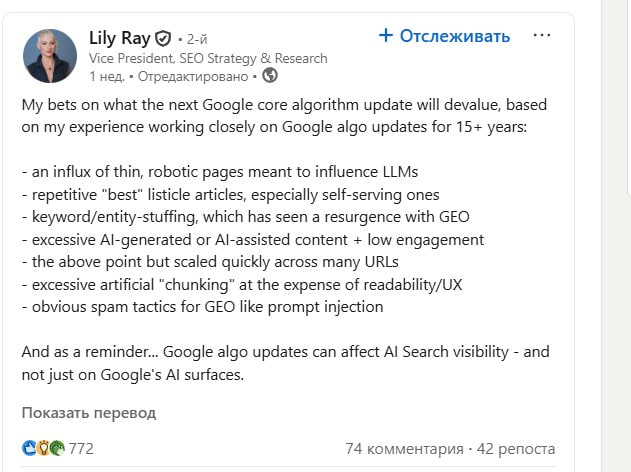

Мои догадки о том, что следующее крупное обновление алгоритма Google будет понижать в выдаче (исходя из 15+ лет опыта наблюдения за апдейтами):

- наплыв тонких, «роботизированных» страниц, созданных, чтобы влиять на LLM

- однотипные статьи-списки вроде “лучшие 10 чего-то”, особенно если это самореклама

- переизбыток ключевых слов и сущностей — то, что снова стало массово применяться из-за GEO

- избыток AI-контента или контента, созданного с помощью AI, с низкой вовлечённостью

- и всё то же самое, помноженное на сотни URL

- искусственное “нарезание” текста (chunking) в ущерб читабельности и UX

- очевидные спам-тактики для GEO, вроде prompt injection

И напоминание: обновления Google Core теперь влияют и на видимость в AI-поиске, а не только на обычные результаты поиска.

Если допустить, что она права, вот какие мысли у меня, как у контентщика-маркетолога:

- Интересно про chunking. В последние годы мы наблюдали тренд на «дробление» текста. Сейчас, получается, тема протухла.

- Про кучу ключей — о, Боже, да. Но не только лишь все это поняли.

- Статьи-списки — тоже все об этом говорят в последнее время, но до сих пор все их заказывают.

- В целом — надо отходить от практики «ключи+структура+факты = текст». Нужно круто развернуться в сторону контент-маркетинга, поиска практик вовлечения и удержания на странице. Использовать текстовый контент, как основу, но выходить за его рамки. И есть у меня несколько теорий на этот счёт.

А вы, что думаете? Насколько точные прогнозы?

Даша,

Главред и контент-маркетолог iGamingTextLab

*выходит за рамки возможного, вот уже одной ногой вышла, смотрите*